1、Deepseek 简介

DeepSeek 是杭州深度求索人工智能基础技术研究有限公司 (成立于2023年7月17日) 研发的推理模型,该模型采用强化学习进行后训练,旨在提升推理能力,尤其擅长数学、代码和自然语言推理等复杂任务。2025年1月20日,DeepSeek 正式发布 DeepSeek-R1 模型,并同步开源模型权重。在部署 DeepSeek 之前,需要安装 Ollama , Ollama 是大型语言模型框架,可以理解为AI模型的宿主,如果需要美观的 UI 界面,需要安装其他应用配合,本教程我们通过部署 OpenWebUI 应用来运行 DeepSeek-R1 模型。

Open WebUI 简介

是一款可扩展的、功能丰富的用户友好型自托管 Web 界面,旨在完全离线运行。它支持包括 Ollama 和与 OpenAl 兼容的 API 在内的多种 LLM 运行器。

Open WebUI 的主要特点

轻松设置:支持 Docker 和 Kubernetes 安装,提供便捷的映像管理。

API 集成:兼容 Ollama 和 OpenAI API,自定义 API URL,适配多个 LLM 服务如 LMStudio 和 OpenRouter。更多详情请查阅 Open WebUI 官方文档。

2、使用 Docker Compose 部署 OpenWebUI 容器(集成 Ollama)

在 UGOS Pro 系统上,推荐使用项目 Docker Compose 快速部署容器,适合需同时管理多个容器的场景,这种方法简化了容器的部署与管理工作。以下是使用 Docker Compose 部署 OpenWebUI 的详细步骤。

2.1 进入 Docker 项目界面

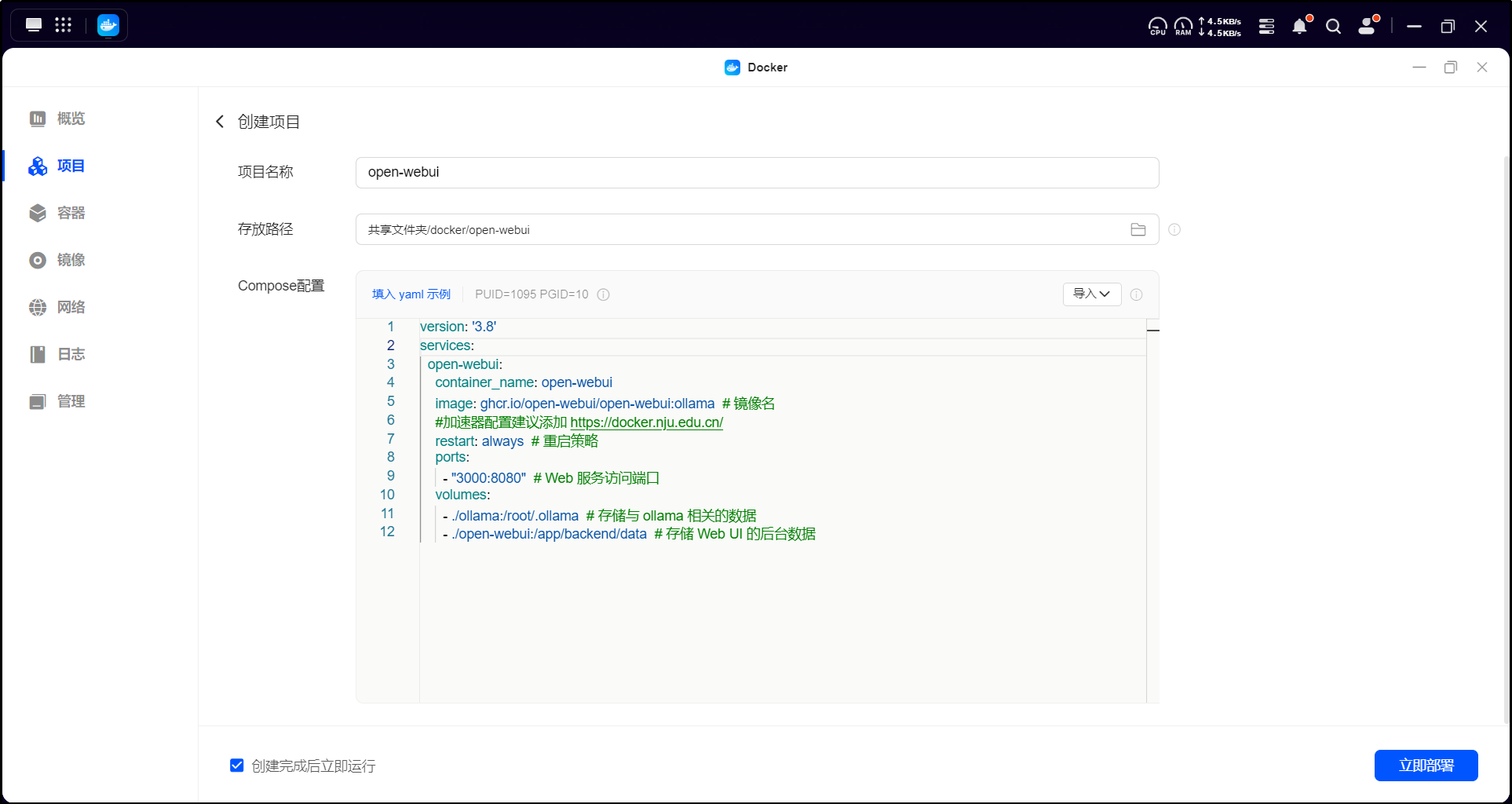

在 UGOS Pro 系统中,打开 Docker 应用,点击【项目】 > 【创建】,启动项目创建向导。

2.2 配置 Docker Compose 文件

在项目创建向导中,上传以下 OpenWebUI 的 Docker Compose 配置文件:

version: '3.8'

services:

open-webui:

container_name: open-webui

image: ghcr.io/open-webui/open-webui:ollama # 镜像名

#加速器配置建议添加 https://docker.nju.edu.cn/

restart: always # 重启策略

ports:

- "3000:8080" # Web 服务访问端口

volumes:

- ./ollama:/root/.ollama # 存储与 ollama 相关的数据

- ./open-webui:/app/backend/data # 存储 Web UI 的后台数据

2.3 参数说明

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

注意:

● 表示当前 Docker Compose 文件所在的目录;

● 冒号前是 NAS 的存储路径,冒号后是容器内的映射路径。

2.4 部署说明

● 镜像来源:使用 镜像,该镜像已集成了 OpenWebUI 和 Ollama,因此无需单独运行 Ollama 服务,系统将自动完成启动与集成。

● 端口设置:OpenWebUI 默认端口为 8080,但可通过 参数调整。本文将其映射到 3000 端口,访问地址为 。Ollama 的默认端口为 11434,但无需暴露,因为镜像内部已完成对接,OpenWebUI 可直接调用 Ollama 服务。

相关阅读

【FAQ】如何在 Docker Compose 配置文件中正确表示 volumes 挂载路径?

2.5 部署项目

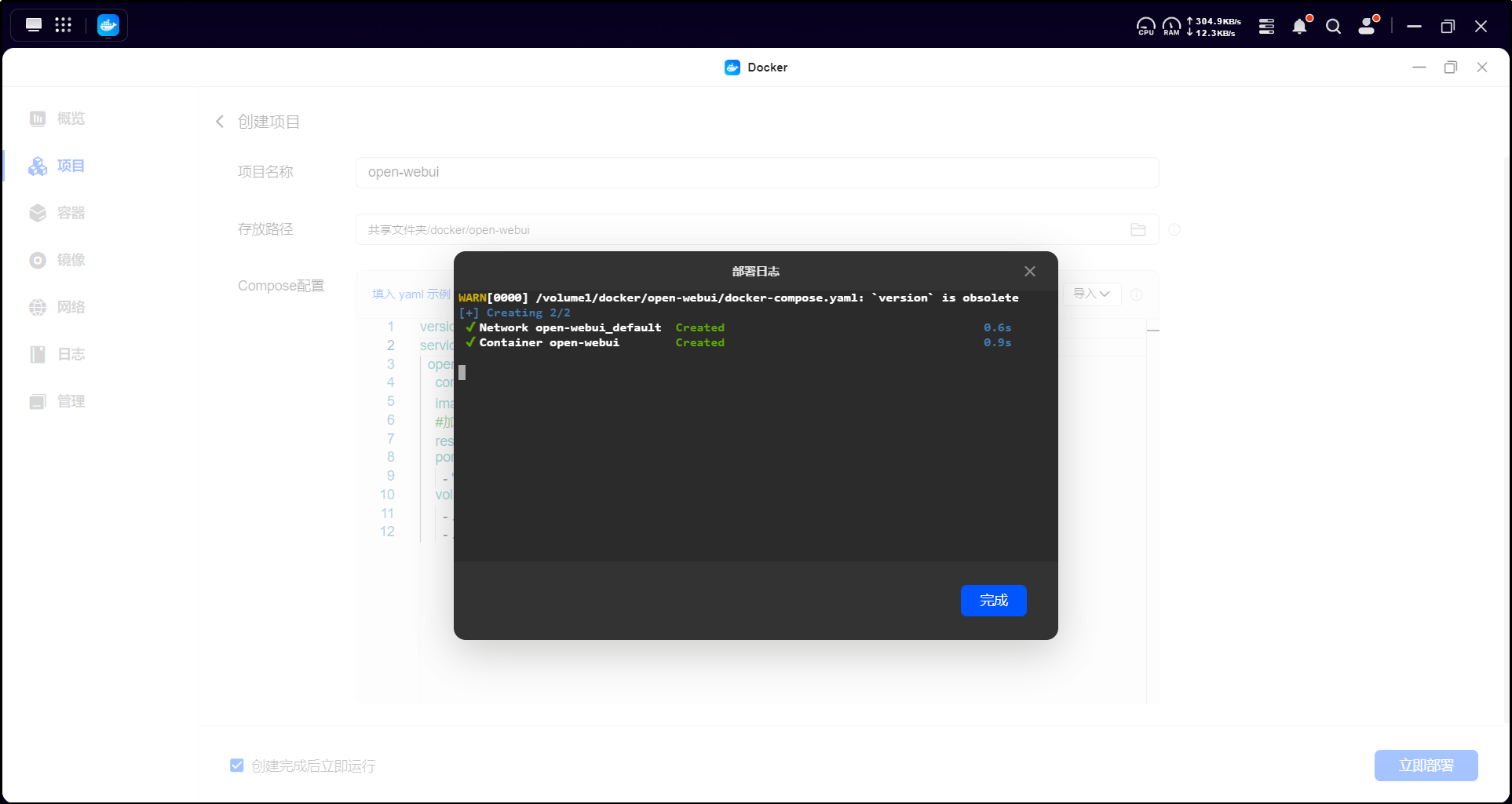

上传配置文件后,点击【立即部署】,系统会自动拉取镜像并启动容器。

完整教程请前往绿联NAS私有云官网阅读:在绿联NAS私有云上本地化部署DeepSeek-R1大语言模型教程

Comments on “在绿联NAS私有云上本地化部署DeepSeek-R1大语言模型教程”